双11期间,淘宝的流量让人咋舌。那么,究竟是什么技术支撑起了如此庞大的流量?这无疑是一个颇具趣味的问题。今天,我们就来聊聊商品浏览环节的技术关键点。

淘宝双11的流量规模

淘宝双11的流量十分庞大。以2020年阿里云公布的订单创建峰值为例,达到了每秒58.3万笔。在用户下单之前,他们会频繁地浏览商品,这样的流量级别至少达到了百万级QPS。由此可见,双11的流量确实令人惊叹,商品浏览的流量在整个流程中占据了很大比例。为了应对如此巨大的流量,技术层面必须进行周密的规划。

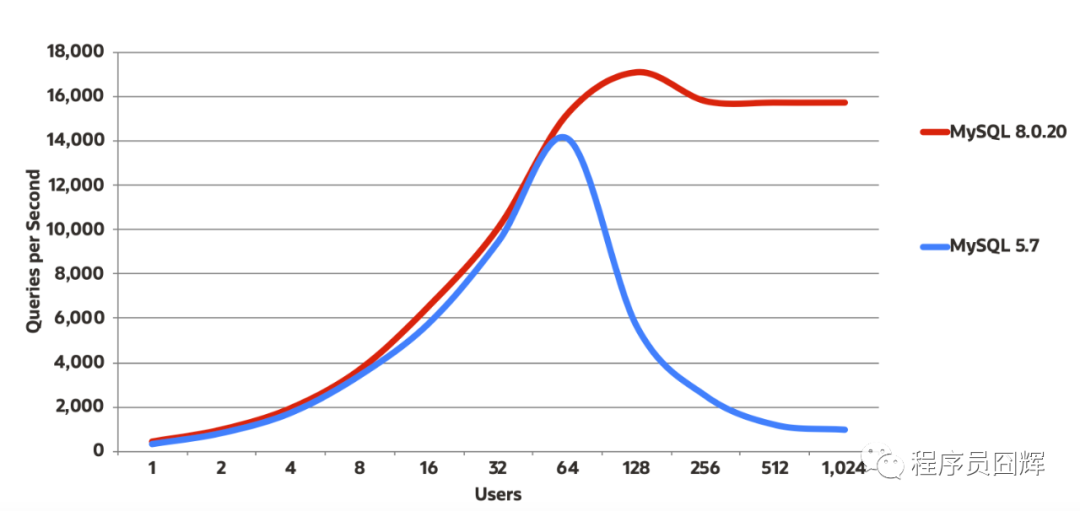

MySQL硬抗不可行

首先得谈谈MySQL。淘宝的数据量相当庞大。根据实践经验,单库的QPS(每秒查询率)建议控制在5000左右较为稳妥。即便能达到1万,也存在一定的风险。就算增加从库,由于从库会占用主库资源,且从库的数量不宜超过20个,想要硬抗百万QPS简直就是天方夜谭。一旦流量涌入,数据库肯定会瘫痪。

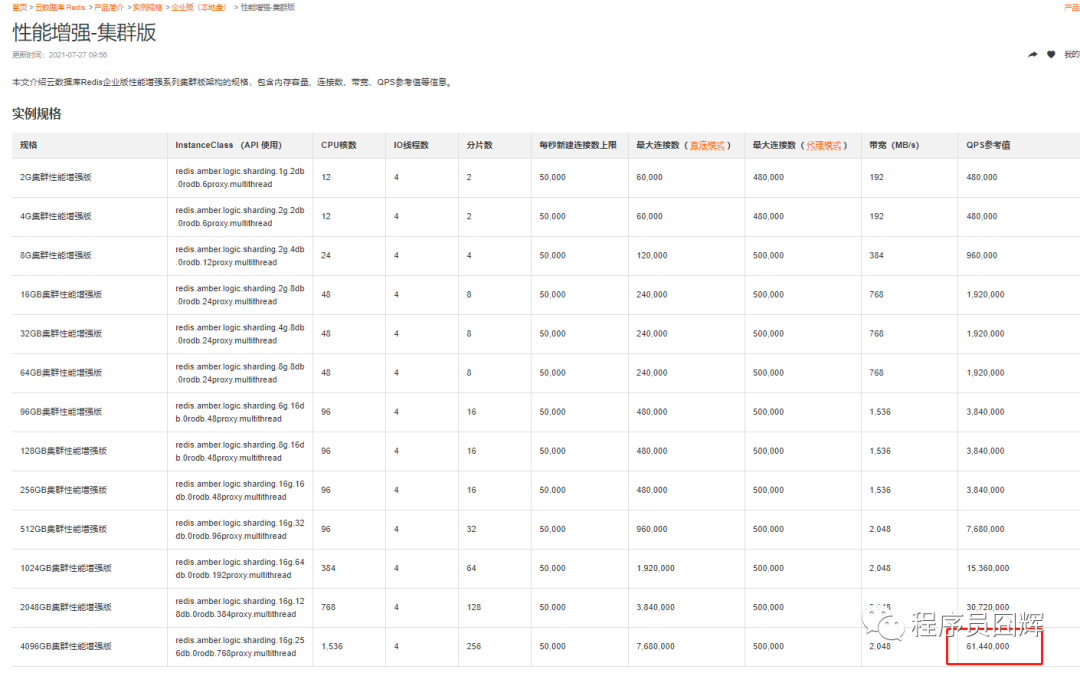

分布式缓存Tair亮相

分布式缓存方面,阿里采用的是自家研发的Tair,若不熟悉,可将其与Redis进行类比。阿里云官网显示,Tair企业版集群版,其性能大幅提升,QPS参考值超过6000万。这一数据相当惊人,从数据表现来看,似乎使用它就能轻松应对商品浏览中的百万级QPS流量挑战。

Tair硬抗也有细节问题

Tair看似操作简便,实则细节不容忽视。使用时不能仅凭QPS数值就贸然采用。比如,在不同应用场景下,是否需要特别调整配置?不同商品的数据类型对缓存有何影响?如此高流量下,即便是微小的疏忽也可能被放大。

成本与效益的考量

无论选用MySQL还是Tair等技术,成本都是一个必须考虑的因素。MySQL虽然理论上难以应对,但若提升硬件配置等投入,成本将显著上升。至于Tair,虽然性能出色,但其部署和维护的费用同样不可忽视。企业必须权衡利弊,不能仅仅着眼于解决流量问题而忽视效益。

技术的综合运用与迭代

应对双11商品浏览的流量高峰,不能仅依赖单一技术手段。这往往需要多种技术的综合运用,并通过持续迭代来优化。比如,可能会将Tair技术与其他优化策略相结合,而且随着时间的发展,技术也在不断更新和进步,以便更好地应对每年双11期间流量的增长。

现在大家不妨思考一下,若是你负责提升双11商品浏览的技术支持,你打算从哪些角度着手?期待大家的点赞、转发,并在评论区畅谈你的见解。

发表评论