这款大模型,刚刚亮相,不仅宣布其性能与顶尖闭源产品相媲美,还以极具竞争力的价格全面进行开源,无疑给整个AI行业投下了一枚震撼弹。

模型性能实现跨越

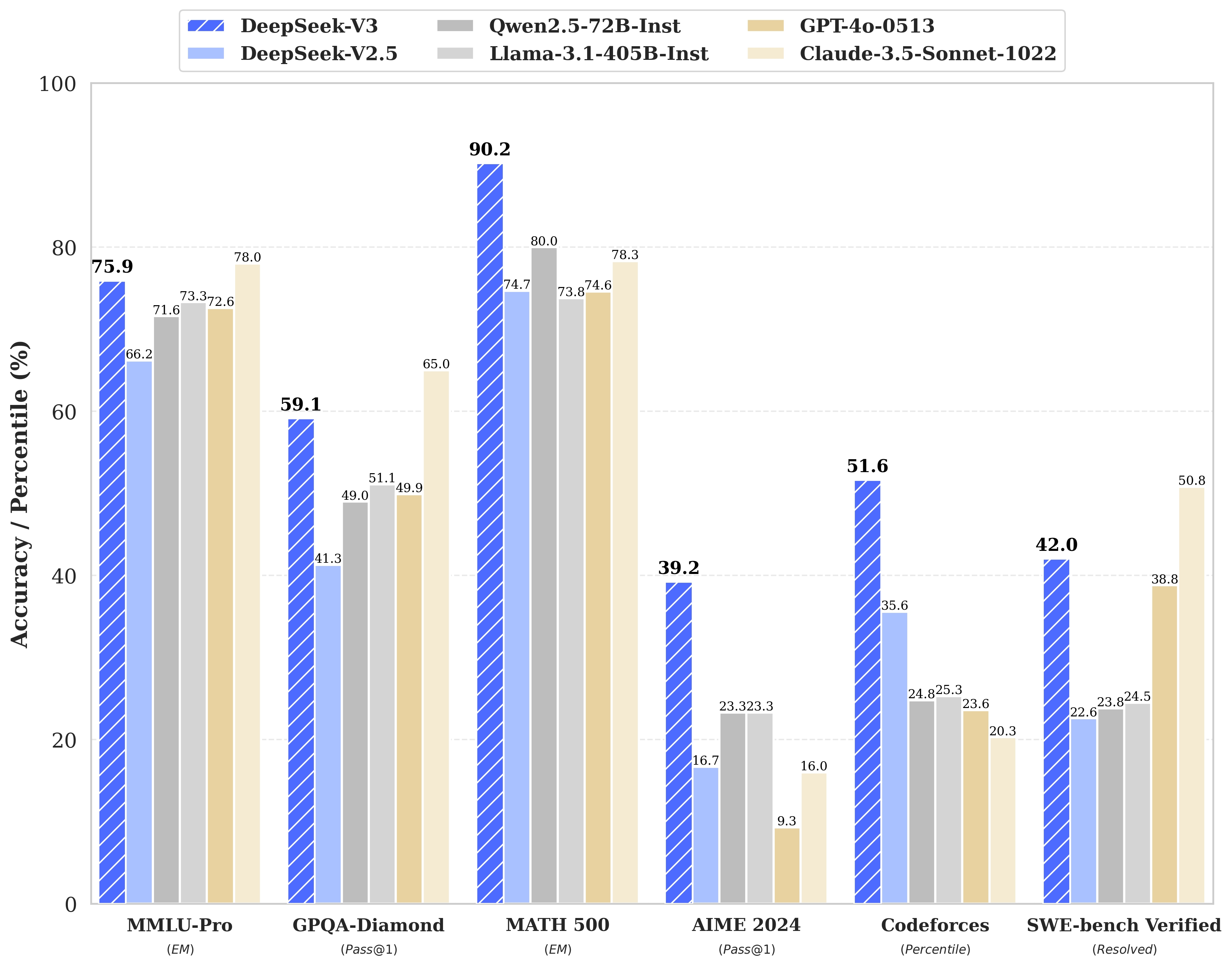

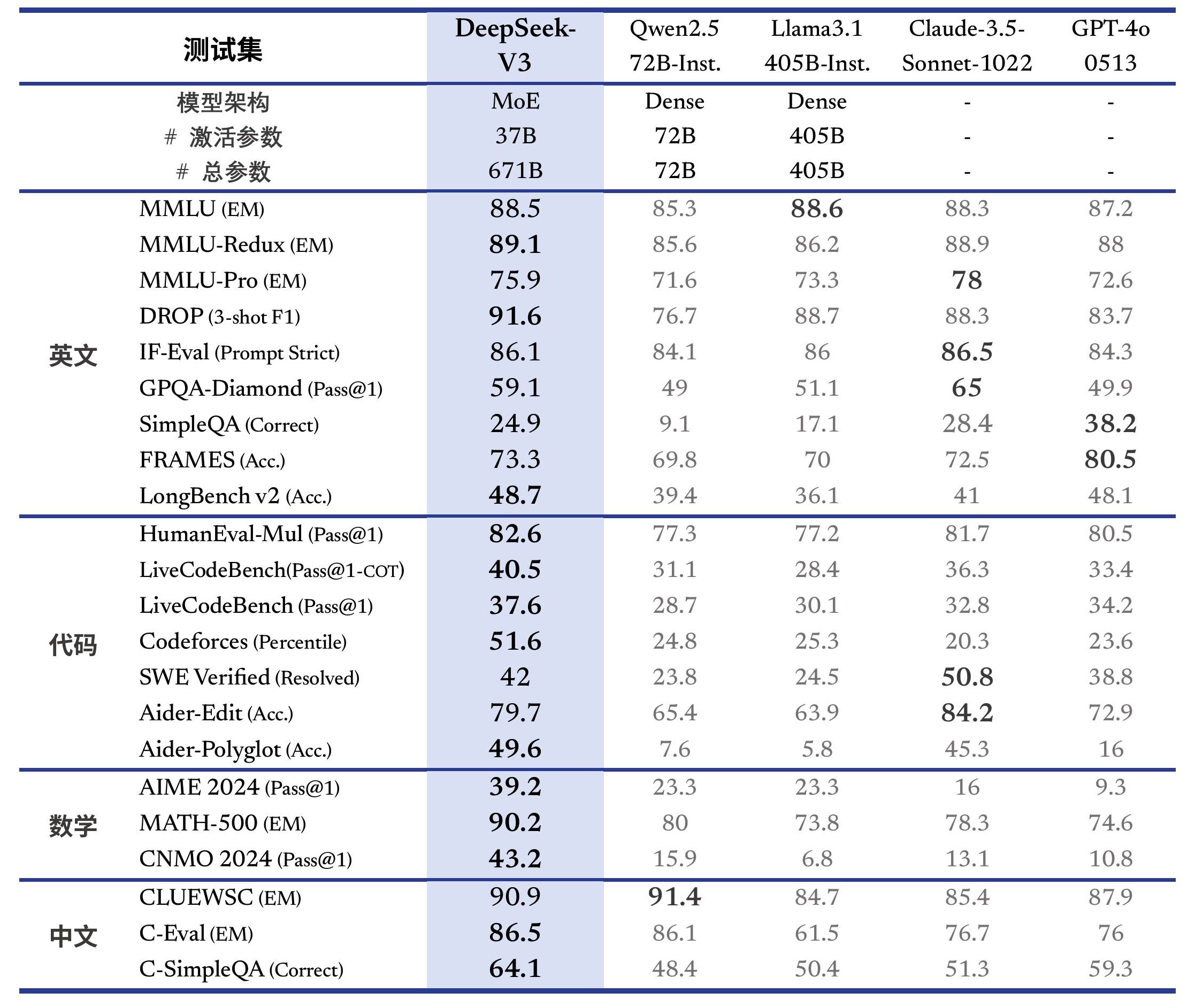

V3模型于多项核心评测里表现显著突出,其综合能力已然超越了先前一些颇有名气的开源大模型,在理解、推理以及代码生成等关键任务方面,此模型展示出了强劲的实力,和当下国际上最为先进的闭源模型相较,在多项基准测试中达成了相近的水准。

这种性能的提升并非意外之事,模型在数量高达14.8万亿的token数据之上展开了全面的预训练,这为它奠定了稳固的知识根基,评测成绩的公开对照,给开发者以及研究者给予了客观的参考,也表明开源模型正在快速地缩减与顶级闭源方案之间所存在的差距。

架构设计与规模优势

该模型构建采用了混合专家架构,其总参数量达6710亿,在实际推理进程里,每次激活的参数量约为370亿,这种设计在确保模型强大能力之际,还明显提升了计算效率,是当前大规模模型发展的一个重要技术方向 。

具有强大能力的物理基础是庞大的参数规模,相较于前代模型,如此巨大的参数量能让其容纳更复杂的模式以及更广泛的知识,自研的MoE架构体现了团队在模型底层设计方面的深入思考与技术积累,这是其实现高性能目标的关键。

推理速度大幅提升

以算法优化以及工程改进为路径,新模型于文本生成速度方面达成了质的跨越,其吐字速率自上一代的每秒20个token显著蹿升至每秒60个token,达成了高达3倍的性能增进,这对于终端用户体验的改良呈现出立竿见影之效。

愈快的响应速率表明用户跟AI对话时的流畅程度愈高,交互感受愈强。不管是开展长文创作、代码调试亦或是复杂问答,等待时间的减少均能够直接提高工作效率以及使用满意度。速度的提高是模型实用化进程里十分切实的一种进步。

API服务与定价策略

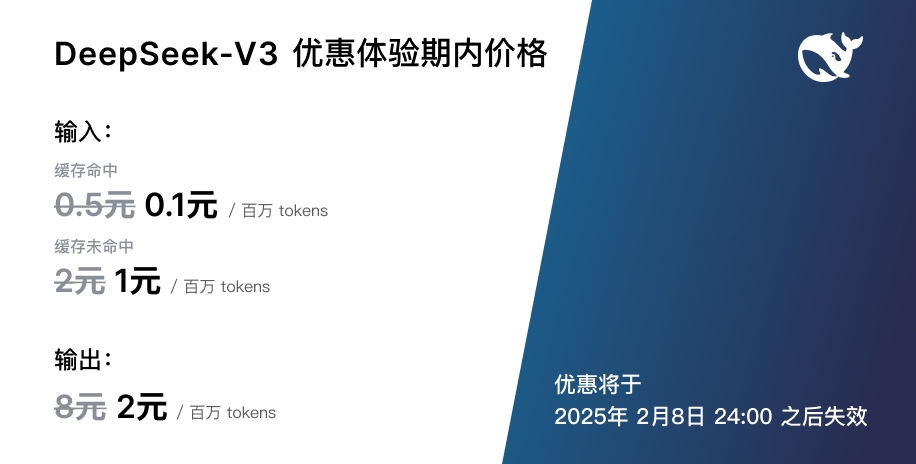

自新模型上线后,其 API 服务的定价随之做了相应调整,新的标准定价是每百万 tokens 输入 0.5 元,输出 8 元 ,官方同时宣告了一个长达 45 天的优惠体验期,在这个期间内,价格会维持在较低水准。

对输入token予以大幅折扣,对输出token也给予大幅折扣处于优惠期定价,这给开发者提供了充足测试时间,给企业提供了充足迁移时间,清晰定价策略,长期优惠安排,显示团队有让用户试用门槛降低的想法,有鼓励更多人体验其最新技术的诚意 。

全面开源与本地部署

这回团队把模型所拥有的原生FP8权重给开源了,而且还迅速获得了主流推理框架的支持,社区能够很方便地去获取模型权重,进而开展本地部署以及深入研究,开源的范围涵盖了从权重一直到转换脚本的一整套完整工具链 。

可为用户提供灵活性选择的数据隐私及成本控制的是本地部署选项。有助于社区在维持精度之际优化推理效率的是开源FP8权重。多家生态伙伴的迅速适配,也证实了该模型于开源社区里的受关注状况和优良的生态兼容性。

未来发展与行业影响

官方清晰表明,这仅是一个全新的起始点,往后计划于现有的基座模型之上,持续去进行深度思考、多模态理解等更为高级的功能开发,并且作出承诺会始终与社区分享进展情况,这展现出了一种秉持开源以及长期发展的技术观念。 。

这次予以发布,进一步证实了开源模型路径具备可行性,高性能模型实施开源,会推动整个AI应用生态走向繁荣,使得更多开发者以及企业能够以相对较低成本运用前沿技术,它有可能促使行业再次对开源与闭源的竞争格局展开思考。

这么一款于性能、速度以及价格方面均能带来惊喜的开源模型,你最为期待借助它去开发怎样的全新应用,抑或是处理你工作生活里的哪些具体问题呢,欢迎于评论区分享你的想法,要是觉得本文有帮助,也请点赞予以支持。

发表评论