停止四处寻觅平替。2025年10月得以最新整理形成的超全面DeepSeek实用指南已呈现,涵盖官方网页版、API调用以及本地部署方面,凭借一文助你解决全部使用难题,使你顺利用上堪与o1相媲美的R1满血版本,重点在于成本尚不足对手的3%。

官网网页版最稳入口

网页版的地址所在之地是chat.deepseek.com ,此乃最为直接的官方途径所在之处。在2025年10月被更新之后 ,网页版所具备的速度以及稳定性均得到大幅度的提升 ,基本上不会呈现出卡顿或者掉线这类状况。你仅仅只需凭借手机号或者邮箱去进行注册便能够实现登录 ,免费的额度也足以满足日常使用所需。

你登录之后,便会发觉界面极为简洁,左侧存在着对话的过程记录,中间区域是用来输入文本的框体。此地已然整合了最新的R1满血版本模型,并不需要你亲自去进行切换操作。要是你有运用AI搜索或者文件上传功能的需求所在,直接于输入框的旁边点击相应按钮就行,它支持上传PDF、Word、Excel等诸多格式。

模型全家桶各有绝活

DeepSeek当下的主力模型是R1满血版,它于推理能力方面已然能够与OpenAI的o1相抗衡,然而其API调用成本仅仅是对方的3%。要是你追寻极致的性能以及性价比,直接选这个就可以。除了R1之外,还存在更轻量的V3版本,这适合日常聊天以及快速响应。

相较于纯文本模型之外,它还对多模态识别予以支持,举例来讲,准许你呈上幅图片,使其对当中文字或者物体加以识别。编程领域存在专门的DeepSeek-Coder模型,其代码生成以及调试能力颇为强大。翻译与创意写作能够借助通用的对话模型,均可出色胜任。

API调用快速接入

从开发者的角度来讲,DeepSeek的API属于当下性价比超高的选择当中的一个,你得先前往官网的开发者平台去注册账号,之后再去创建一个应用从而获取API Key,其接口地址和多数主流模型存有兼容性,接入的门槛是很低的。

说起价格,R1满血版的输入token价格远比行业平均水平低好多,其输出价格同样具备较强竞争力。官方给出了Python以及Node.js的SDK,只需寥寥�行代码便利索调用。国内服务器调用时延迟程度不高,极为契合集成到自身应用或者工作流里。

本地部署自己动手

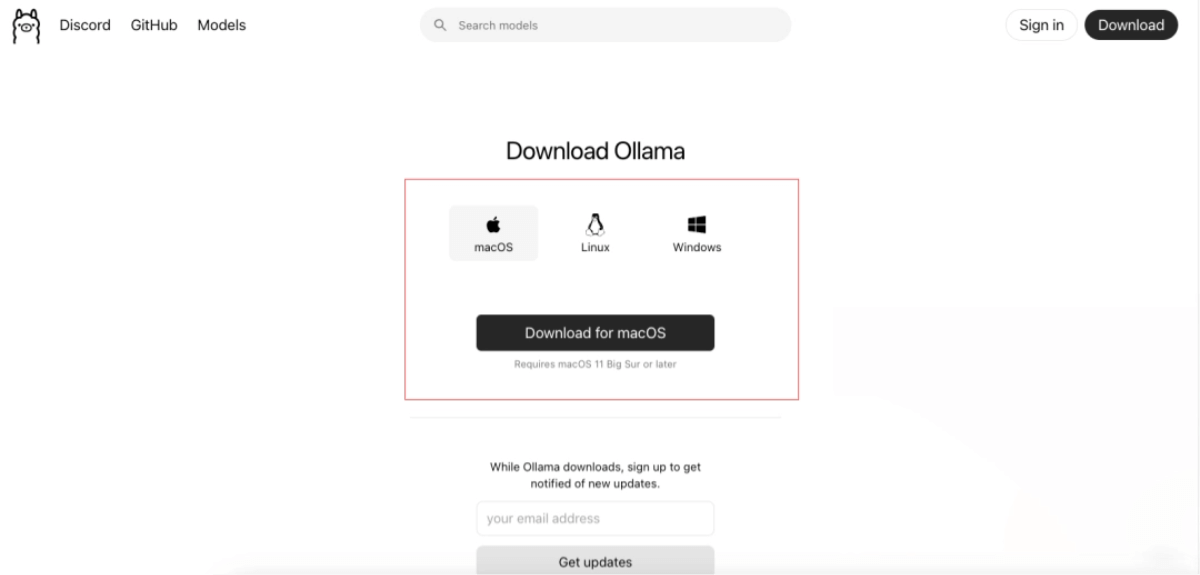

若想对数据达成全然的掌控,那么本地部署会是最为理想的选择。在此推荐运用Ollama这一工具,它对Windows、Mac以及Linux系统均予以支持。首先要前往Ollama官网,去下载契合你电脑系统的版本,就如同安装平常的软件那样将其安装妥当,如此一来你便能够在电脑上瞧见它的图标了。

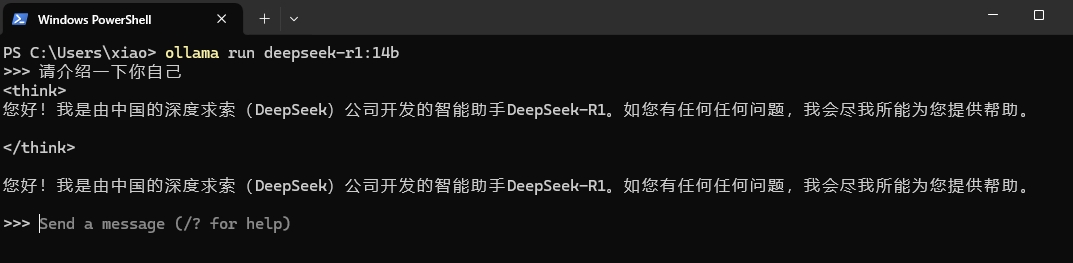

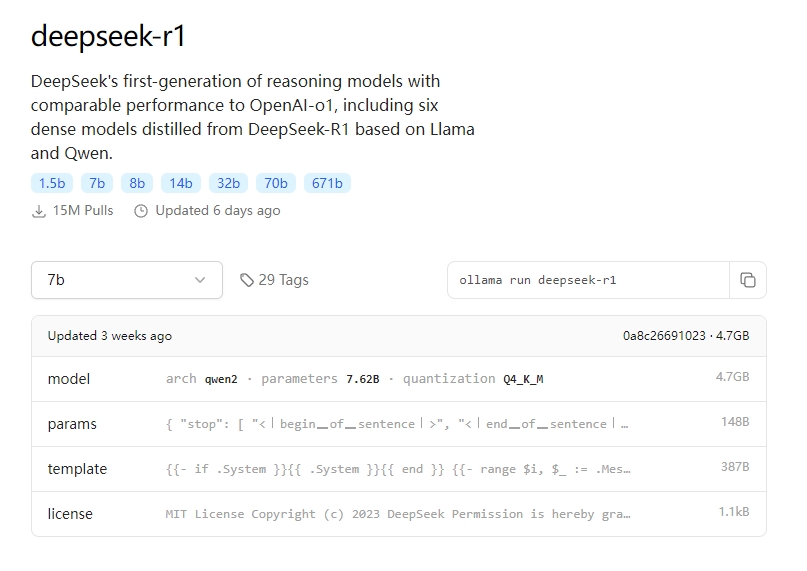

于安装结束之后,开启电脑的终端命令行的工具。键入命令“ollama run deepseek-r1:32b”便能够着手下载R1模型的32B参数版本。依据你的网络速度,下载兴许需花费几分钟至半小时。在下载完成之后,直接于终端就能与之对话的,输入“介绍一下你自己”予以测试,等待回复便可。

本地部署更多玩法

倘若你发觉于终端里进行对话不太便利,那么可搭配一个图形界面。Open WebUI是个挺好的选择,它能够使你的本地模型具备类似GPT的网页交互界面。借助Docker能够迅速部署这个UI,之后连接到本地的Ollama服务。

数据完全不上传,如此这般就使得本地部署具备了充分的好处,这让隐私性得以十足拉满。并且,Ollama并非仅仅支持DeepSeek,要是你打算去更换其他的开源模型,像Llama或者Qwen这样的类型,同样能够运用这个工具来实施管理。常用的Ollama命令其实也就仅有几个,举例来说,“ollama list”能够用于查看已被下载的模型,而“ollama rm”则是用来删除那些毫无必要的模型。

模型云部署更方便

设想一下,要是本地电脑之配置,不足以支撑运行32B模型,然而又不想自行去编写代码以调用API,那么,此时便能够考虑采用云部署方案。注意啦,一些国内的云平台,已然上架了DeepSeek的镜像,于此情形下,你能够租用云端的GPU实例,通过一键操作来部署属于自己的专属服务,并且是按照使用时长来支付费用的。

这种方案躲开了本地硬件的限制,还拥有比径直调用官方_API更多的定制化空间。你能够随意配置模型参数,甚至拿私有数据对模型予以微调。针对团队协作或者需要高并发响应的场景来讲,云部署乃是平衡成本、性能以及隐私的不错选择。

浏览完这份于2025年10月推出的最新版本的使用指南后,你是有意先从网页版着手进行初次体验,还是径直尝试本地部署呢?欢迎于评论区讲述你的使用感受,对此点赞收录以便能够随时去查看,切莫忘记转给那般同样对AI助手有需求的朋友们呀!

发表评论